Threat Spotlight : Les robots malveillants évoluent pour devenir plus « humains »

L’univers des robots est en train de changer. Les mauvais robots, c’est-à-dire ceux utilisés à des fins malveillantes, sont en train d’évoluer pour devenir plus sophistiqués. Ils commencent à manifester un comportement plus humain. D’autre part, des robots d’une catégorie émergente sont récemment apparus. Ces nouveaux venus, que l’on pourrait appeler les « robots gris », sont basés sur l’IA et brouillent de plus en plus la ligne de démarcation entre les activités légitimes et les autres.

Les chercheurs en sécurité de Barracuda ont analysé certains événements en rapport aux robots. Ils se sont plus particulièrement intéressés au trafic et aux activités ayant ciblé des applications web ou des API entre septembre 2023 et fin août 2024. Entre autres choses, ils ont découvert que :

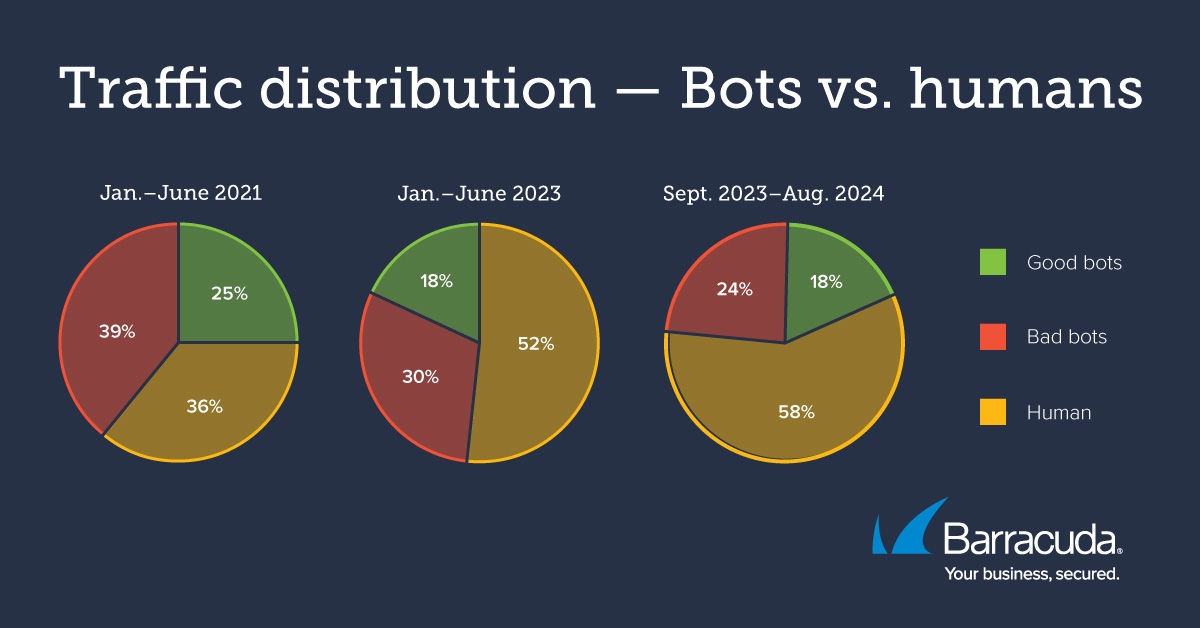

- Les robots malveillants représentent 24 % du trafic sur Internet en 2024, contre 39 % en 2021.

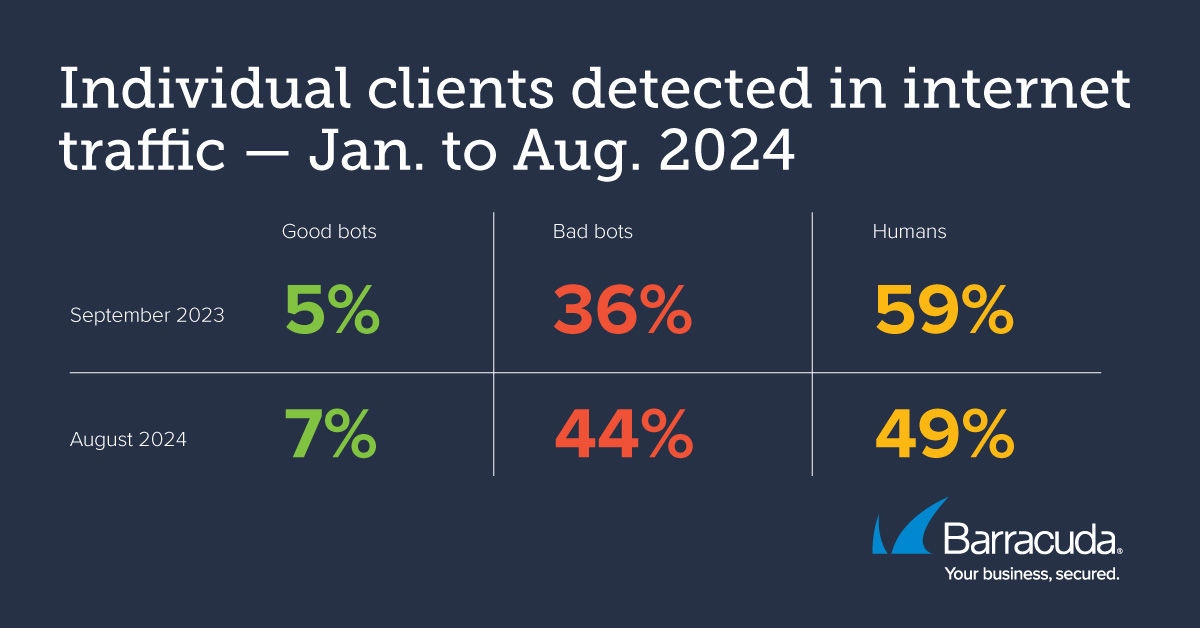

- Le nombre total de types de robots malveillants a augmenté. Il représente désormais 44 % du nombre de clients détectés, contre 36 % il y a un an.

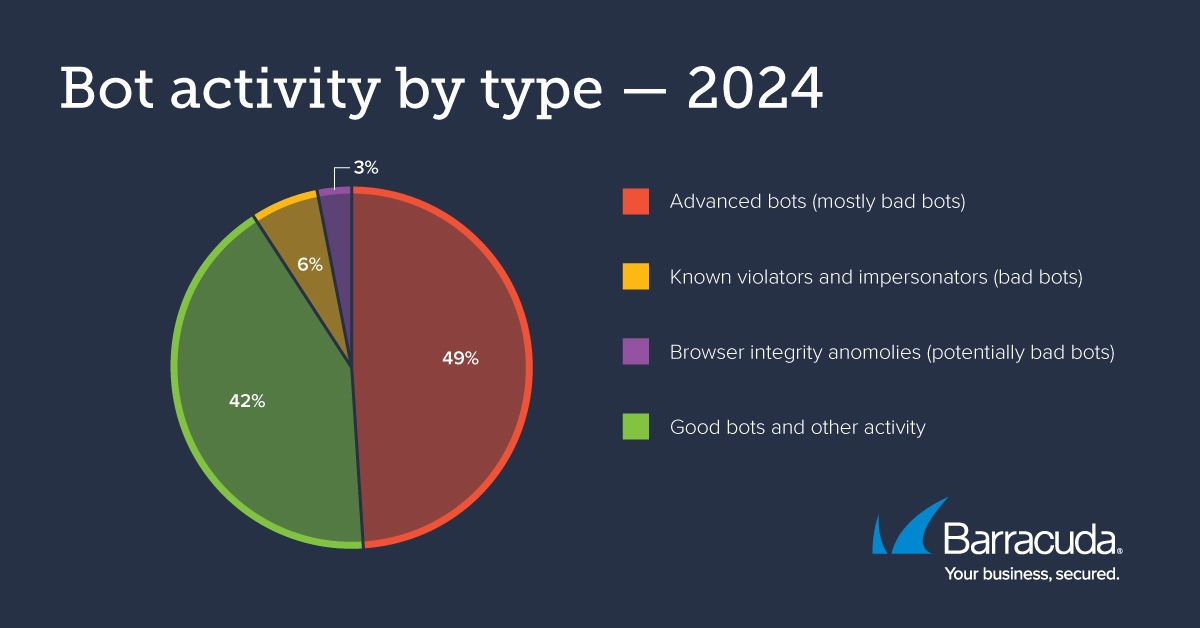

- 49 % des robots appartiennent à la catégorie des « robots sophistiqués ». La plupart de ces agents sont de nature malveillante, étant conçus pour imiter le comportement humain en vue de participer à des interactions complexes en ligne, comme des piratages de compte impliquant des communications avec leurs cibles.

Le paysage des bots en 2024

Les robots, ou bots, sont des logiciels automatisés conçus pour mener à bien certaines tâches en ligne à grande échelle. Les bons robots comprennent ceux qui se livrent à l’indexation du web, ceux consacrés au référencement naturel et les robots de service à la clientèle. Ces outils légitimes peuvent aider les organisations à rationaliser leurs processus, à accroître leur efficacité, à renforcer leur présence en ligne et à mieux servir leurs clients.

Les mauvais robots, eux, sont des outils conçus pour se livrer à des activités malveillantes ou nuisibles en ligne. Leurs cibles sont diverses : il peut s’agir de sites web, de serveurs, d’interfaces de programmation d'applications (API) ou d'autres terminaux. Ces mauvais robots ciblent notamment les sites web consacrés au commerce électronique et les pages de connexion. Leurs manœuvres visent à accéder frauduleusement à des comptes de clients, l’objectif pouvant être de se procurer des données personnelles ou de commettre des escroqueries. Pour parvenir à leurs fins, ces robots tirent parti des vulnérabilités des sites présents sur le web. Ils peuvent, par exemple, surcharger leurs cibles de trafic, diffuser des courriers indésirables, fausser des analyses commerciales, perturber des services pour des clients légitimes, nuire à la réputation d’entreprises, etc.

L’émergence des « robots gris » basés sur l’IA

Les chercheurs en sécurité de Barracuda ont également remarqué l’émergence d’une nouvelle catégorie de robots. Basés sur l’IA, ces nouveaux outils pourraient être classés comme des « robots gris » car, bien qu’ils ne soient pas véritablement malveillants, leur mode opératoire peut être équivoque.

Ces robots basés sur l'IA sont principalement destinés à extraire de gros volumes de données sur des sites web, par exemple pour servir à l’apprentissage de modèles d'IA générative. Ils sont parfois trop ardents lorsqu’ils recueillent des données, et ils sont susceptibles de se procurer des informations sans en avoir la permission. Ils peuvent aller jusqu’à ignorer les fichiers robots.txt, documents intégrés aux sites web pour signaler aux robots qu’ils ne doivent pas extraire certaines des données qu’ils trouvent.

La dynamique changeante entre les robots et les êtres humains

La répartition du trafic entre robots et êtres humains

De septembre 2023 à fin août 2024, les bons robots représentaient 18 % du trafic sur Internet, tandis que les mauvais en représentaient 24 % et les utilisateurs humains 58 %.

La proportion de trafic imputable aux robots malveillants diminue d’année en année. En 2023, les mauvais robots représentaient 30 % du trafic en ligne, contre 39 % en 2021.

À quoi est due cette baisse générale constatée du volume de trafic imputable aux robots malveillants ? Selon nos chercheurs, la cause de la baisse pourrait être double : une prise de conscience croissante de la menace constituée par ces robots, et un moindre usage de ces outils pour les achats en masse.

De plus en plus d'entreprises sont conscientes des dégradations que les robots malveillants peuvent causer à leurs applications web. Elles prennent donc des mesures pour détecter et bloquer le trafic provenant de robots malveillants ou suspects. En conséquence, le taux de réussite des attaques recourant à des robots malveillants a été réduit, et ces outils sont devenus moins attrayants pour les pirates.

Quant à l’autre facteur, remontons à 2021. Cette année-là, des kyrielles de robots d’achat ciblaient les sites de commerce électronique pour s’emparer de biens de consommation de grande valeur, les articles achetés étant ensuite revendus à des prix excessifs. Ces robots malveillants comprenaient les fameux « sneaker bots », qui recherchaient les séries limitées de chaussures. Lorsque le marché pour ces produits s’est effondré pendant la récession, l’usage de robots pour les achats en masse a diminué, ce qui a entraîné une réduction du volume de trafic dû aux robots malveillants.

Aujourd’hui, les robots utilisés sont devenus plus sophistiqués et spécialisés.

L’activité des robots malveillants en 2024

Nos chercheurs en sécurité ont également examiné les activités automatisées détectées entre janvier et fin août 2024.

Les données recueillies montrent que ces activités ont été dominées en 2024 par des « robots sophistiqués » et que la plupart de ces outils sont indubitablement malveillants.

- Les robots sophistiqués : Ils représentent 49 % de l'activité totale des robots, et leurs contributions sont surtout malveillantes. Ces mauvais robots recourent à des techniques sophistiquées pour imiter les comportements humains. Ils sont capables de gérer des interactions complexes sur le web. Ils parviennent à contourner les mesures conventionnelles de contrôle basées sur les volumes de trafic, les taux d'erreurs, les tests CAPTCHA et les adresses IP. Parmi eux, mentionnons les robots conçus pour le piratage de comptes. Pour parvenir à leurs fins, ces robots utilisent parfois une diversité de méthodes, et leurs attaques suivent souvent la méthode dite « discrète et lente » : ils tirent parti d’adresses IP et de localisations géographiques multiples pour ne pas être détectés. Notons cependant que certains robots évolués peuvent être catégorisés par erreur comme malveillants. Ce peut être le cas, par exemple, de certains outils bénins destinés à l’indexation du web, ou encore de robots qui utilisent des mécanismes complexes pour éviter d'être bloqués.

- Les imitateurs : Il s’agit de robots évolués conçus pour imiter les comportements humains. Ces outils sont généralement destinés à commettre des actes malveillants, comme des escroqueries. Par exemple, un de ces robots pourrait essayer de se faire passer pour un outil d’indexation de Google afin de pouvoir recueillir des informations sans être bloqué.

- Les transgresseurs connus : Ces agents ont déjà été remarqués en train de se livrer à des activités indésirables ou malveillantes. Comme ils ont déjà été repérés par des outils de sécurité, ces robots ne peuvent plus accéder aux applications protégées. Les transgresseurs connus représentaient 6 % de l’activité analysée au cours de la période couverte par notre étude.

- Les anomalies liées à l'intégrité des navigateurs : Elles concernent des clients pour lesquels des configurations anormales ont été détectées en rapport aux navigateurs, ces particularités pouvant indiquer des tentatives d’imitation. Cette catégorie représentait 3 % de l’activité globale.

Les détections d’activités légitimes émanant de robots

- Les outils d’indexation : Ces robots servent principalement à indexer le contenu des sites web pour les moteurs de recherche.

- Les extracteurs de données pour les flux : Ils recherchent du contenu pour les flux web, les agrégateurs ou la diffusion d'actualités.

- Les robots de référencement : Il s’agit d’agents qui interagissent avec les systèmes d’une entreprise. Ils servent à optimiser le positionnement d’un contenu en ligne sur les moteurs de recherche.

- Les agents des réseaux sociaux : Ces outils automatisés se livrent à des opérations de gestion ou d’interaction en rapport aux plateformes sociales en ligne.

- Les partenaires techniques ou robots commerciaux : Ce sont des outils gérés par des entreprises tierces à des fins d’intégrations de services ou de contenu.

- Les autres outils : Certains robots sont des clients destinés à l’exécution de tests, de contrôles ou d'autres tâches opérationnelles.

Avec d’autres catégories, les bons robots représentent 42 % des activités sur Internet en 2024.

Comment protéger votre organisation ?

Pour préserver la sécurité et l'intégrité de vos activités en ligne, il est essentiel que vous compreniez la menace représentée par les robots malveillants et que vous preniez les mesures qui s’imposent. Il est impératif de vous protéger contre le recueil d’informations sur vos prix, ainsi que contre les achats en masse et les transactions frauduleuses. Pensez également à bloquer les courriers indésirables, à éliminer les comptes frauduleux et à empêcher les campagnes de désinformation de se propager sur les médias sociaux. Les données confidentielles que vous gérez doivent être sécurisées, et vous devez vous prémunir contre les tactiques de référencement qui visent à nuire à votre classement sur les moteurs de recherche. Pour finir, veillez à ce que les connexions effectuées sur votre site soient légitimes.

Avec des mesures de protection efficaces et ciblées contre les robots, vous pouvez détecter les attaques automatisées menées par des agents malveillants et vous pouvez vous prémunir contre ces attaques. Par contre, en ce qui concerne les robots connus pour leur utilité, laissez-les explorer votre application web — pour, par exemple, indexer et référencer votre contenu sur les moteurs de recherche.

Un système de protection efficace doit s’étendre à une multiplicité d’éléments. Voici une liste de points importants :

- **Procurez-vous un dispositif de sécurité robuste pour vos applications.**Sécurisez vos applis web et vos API en installant un logiciel sophistiqué destiné à la protection des applications. Assurez-vous que ce dispositif de sécurité est correctement configuré, notamment pour surveiller et limiter les débits de trafic. Cette mesure constitue une première étape importante pour assurer le bon fonctionnement du système de protection de vos applications.

- Protégez-vous en particulier contre les robots. Lorsque vous choisissez le produit qui sécurisera vos applications, assurez-vous qu’il comprend une protection antirobot. Vous pourrez ainsi détecter et bloquer efficacement les attaques menées par des agents automatisés sophistiqués.

- Tirez parti de l’apprentissage automatique.Optez pour un dispositif de protection qui met à profit le potentiel considérable de l’intelligence artificielle. Cet atout vous permettra de détecter et de bloquer efficacement les attaques furtives qui recourent à des robots « presque humains ». Ne manquez pas non plus d’activer un outil de protection contre le bourrage d’identifiants, afin d’empêcher le piratage des comptes que vous gérez.

- N'oubliez pas les éléments fondamentaux. Les contrôles sur les accès et les authentifications, par le biais notamment de l'authentification multifacteur, contribuent à protéger les pages de connexion et les autres points d'accès vulnérables. Ce type de précautions est utile contre les attaques par force brute et le bourrage d'identifiants.

Les attaques automatisées sont en pleine évolution et sont devenues sophistiquées. Pour en découvrir davantage sur la manière de défendre votre environnement contre ce type de menaces, référez-vous à notre site web.

Rapport 2025 sur les ransomwares

Principales conclusions concernant l’expérience et l’impact des ransomwares sur les organisations du monde entier

S’abonner au blog de Barracuda.

Inscrivez-vous pour recevoir des informations sur les menaces, des commentaires sur le secteur et bien plus encore.

Sécurité des vulnérabilités gérée : correction plus rapide, risques réduits, conformité simplifiée

Découvrez à quel point il peut être facile de trouver les vulnérabilités que les cybercriminels cherchent à exploiter