Les bots sont des programmes logiciels automatisés conçus pour mener à bien des activités en ligne à grande échelle. Il existe des bots non malveillants, tels que les robots d’exploration des moteurs de recherche, les bots de référencement et les bots du service client, et de mauvais bots, conçus pour des activités en ligne malveillantes ou nuisibles, telles que la violation de comptes pour voler des données personnelles ou commettre des fraudes.

Entre ces deux catégories, vous trouverez ce que Barracuda appelle des « bots gris ». Les bots de scraping basés sur l’IA générative sont des bots gris conçus pour extraire de gros volumes de données des sites web, souvent pour entraîner des modèles d’IA générative. D’autres exemples de bots gris sont les bots de récupération (ou scraping) de contenu web et les agrégateurs de contenu automatisés qui collectent du contenu web tel que des actualités, des avis, des offres de voyage, etc.

Les bots gris brouillent les frontières de l’activité légitime. Ils ne sont pas ouvertement malveillants, mais leur approche peut être discutable. Certains sont très agressifs.

Nous avons récemment expliqué comment les organisations peuvent mieux protéger leurs applications web, y compris leurs sites web, contre les bots de scraping basés sur l’IA générative. Dans ce rapport, nous examinons ce que les données nous apprennent sur l’activité des bots gris basés sur l’IA générative – une activité à laquelle les entreprises d’aujourd’hui sont confrontées.

Les bots gris sont affamés

Les données de détection de Barracuda montrent que :

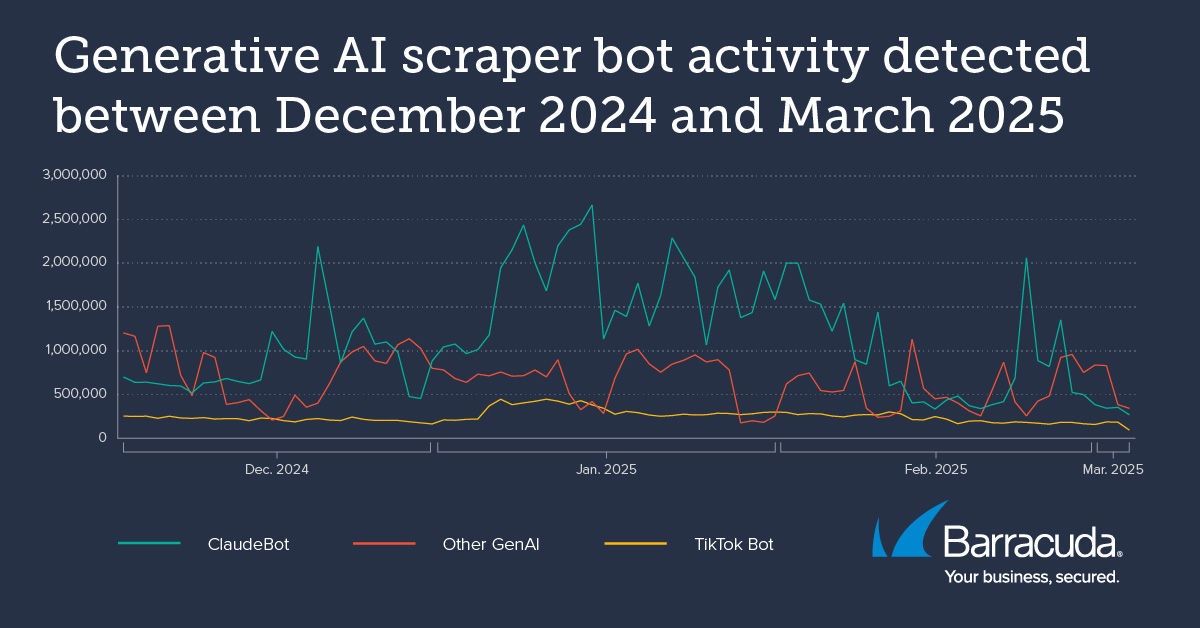

- Entre décembre et fin février 2025, des millions de requêtes ont été reçues par des applications web provenant de bots d’IA générative, notamment ClaudeBot et le bot Bytespider de TikTok.

- Une application web suivie a reçu 9,7 millions de requêtes de bots de scraping alimentés par l’IA générative sur une période de 30 jours.

- Une autre application web suivie a reçu plus d’un demi-million de demandes de bots de scraping alimentés par l’IA générative en une seule journée.

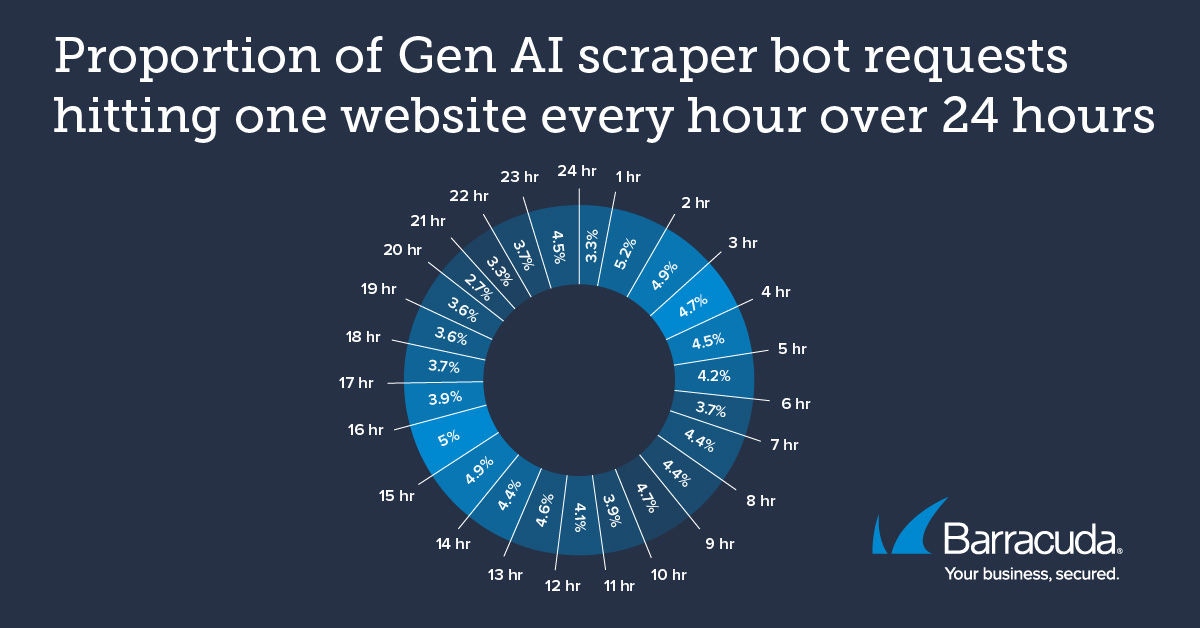

- L’analyse du trafic des bots gris ciblant une autre application web suivie a révélé que les requêtes sont restées relativement constantes sur 24 heures, soit une moyenne d’environ 17 000 requêtes par heure.

Cette cohérence du trafic de requêtes était inattendue. On suppose généralement, et c’est souvent vrai, que le trafic des bots gris arrive par vagues, atteignant un site web pendant quelques minutes à une heure environ avant de retomber. Les deux scénarios, à savoir un bombardement constant ou des pics de trafic ponctuels et inattendus, présentent des défis pour les applications web.

Impact sur les entreprises

Les bots gris peuvent être agressifs lorsqu’ils collectent des données et peuvent supprimer des informations sans autorisation. L’activité des bots gris peut submerger le trafic des applications web, perturber les opérations et recueillir de vastes volumes de données créatives ou commerciales exclusives.

L’extraction et l’utilisation ultérieure de données protégées par des droits d’auteur par des modèles d’entraînement d’IA peuvent constituer une violation des droits légaux des propriétaires.

Le scraping répété des bots augmente la charge du serveur, ce qui peut dégrader les performances des applications web et avoir une incidence sur l’expérience des utilisateurs.

Cela peut également augmenter les coûts d’hébergement des applications en raison de l’augmentation de l’utilisation du processeur cloud et de la consommation de bande passante.

De plus, la présence de bots de scraping alimentés par l’IA peut fausser les analyses des sites web, ce qui rend difficile pour les organisations de suivre le comportement réel des utilisateurs et de prendre des décisions commerciales éclairées. De nombreuses applications web s’appuient sur le suivi du comportement des utilisateurs et des flux de travail courants pour prendre des décisions basées sur les données. Les bots alimentés par l’IA générative peuvent déformer ces mesures, ce qui conduit à des informations trompeuses et à une mauvaise prise de décision.

Il existe également des risques liés à la confidentialité des données. Certains secteurs, comme la santé et la finance, peuvent être confrontés à des problèmes de conformité si leurs données propriétaires ou les données de leurs clients sont récupérées.

Enfin, les utilisateurs et les clients pourraient remettre en question la fiabilité d’une plateforme si du contenu généré par l’IA l’envahit ou si leurs données sont utilisées sans leur consentement.

Nuances de gris

Les bots gris alimentés par l’IA générative les plus prolifiques détectés début 2025 incluent ClaudeBot et le bot de TikTok (Bytespider).

ClaudeBot

ClaudeBot est de loin le bot gris basé sur l’IA générative le plus actif de notre ensemble de données. ClaudeBot collecte des données pour former Claude, un outil d’IA générative destiné à un usage quotidien généralisé.

Les requêtes incessantes de ClaudeBot sont susceptibles d’avoir un impact sur bon nombre de ses applications web ciblées. Anthropic, la société qui a créé Claude, propose sur son site web du contenu qui explique comment ClaudeBot se comporte et comment bloquer l’activité des scrapeurs.

Ce type de contenu apparaît également sur les sites web de certains autres bots gris repérés par les systèmes de détection de Barracuda, notamment OpenAI/GPTbot et Google-Extended.

TikTok

TikTok est un service d’hébergement de vidéos de courte durée qui compte un peu plus de deux milliards d’utilisateurs dans le monde. Il appartient à la société Internet chinoise ByteDance, qui utilise un bot de scraping basé sur l’IA appelé Bytespider pour former des modèles d’IA générative. Les données permettent à TikTok de connaître les dernières préférences et tendances des utilisateurs, ce qui contribue à améliorer le moteur de recommandation de contenu de TikTok et d’autres fonctions basées sur l’IA, telles que la recherche de mots-clés pour la publicité. Bytespider a été signalé comme étant particulièrement agressif et sans scrupules.

Deux autres bots de scraping basés sur l’IA générative détectés par les systèmes Barracuda fin 2024/début 2025 sont PerplexityBot et DeepSeekBot.

Empêchez les bots gris d’entrer

Les données suggèrent que les bots gris, tels que les bots basés sur l’IA générative, sont désormais une composante quotidienne du trafic de bots en ligne et qu’ils sont là pour durer. Il est temps pour les organisations d’en tenir compte et de les intégrer dans leurs stratégies de sécurité.

Il existe des directives pour les sites web et les entreprises à l’origine les bots basés sur l’IA générative. Par exemple, les sites web peuvent déployer un fichier robots.txt. Il s’agit d’une ligne de code ajoutée au site web qui signale à un scraper qu’il ne doit pas prendre les données de ce site.

Le fichier robots.txt n’est pas juridiquement contraignant. De plus, pour que le fichier robots.txt soit efficace, le nom spécifique du bot de scraping doit être ajouté. Cela permet aux bots gris moins scrupuleux d’ignorer le paramètre robots.txt ou de dissimuler le nom spécifique de leur scraper ou de le modifier régulièrement.

Pour vous assurer que vos applications web sont protégées contre l’impact des bots gris, envisagez de mettre en place une protection contre les bots capable de détecter et de bloquer l’activité des bots de scraping basés sur l’IA générative.

Par exemple, la solution Advanced Bot Protection de Barracuda s’appuie sur des technologies avancées d’IA et d’apprentissage automatique pour faire face aux menaces uniques posées par les bots gris, grâce à la détection basée sur le comportement, à l’apprentissage automatique adaptatif, à la prise d’empreintes digitales complète et au blocage en temps réel.

Les bots basés sur l’IA générative ne sont pas seulement une tendance passagère : comme le montrent nos données, ils sont désormais courants et persistants. Les débats éthiques, juridiques et commerciaux autour des bots devraient se poursuivre pendant un certain temps. En attendant, en mettant en œuvre les bons outils de sécurité, vous avez l’assurance que vos données restent uniquement entre vos mains.

Rapport 2025 sur les violations de la sécurité des e-mails

Principales conclusions concernant l’expérience et l’impact des failles de sécurité des e-mails sur les organisations du monde entier

S’abonner au blog de Barracuda.

Inscrivez-vous pour recevoir des informations sur les menaces, des commentaires sur le secteur et bien plus encore.

Rapport d’informations de 2025 sur les clients des fournisseurs de services managés

Panorama mondial sur les besoins et attentes des organisations vis-à-vis de leurs fournissuers de services managés en cybersécurité