5 façons dont les cybercriminels utilisent l’IA : les deepfakes

Les cybercriminels trouvent toujours de nouvelles façons de faire les choses, et c’est certainement vrai pour l’intelligence artificielle (IA). Nous avons vu comment ils utilisent l’IA dans les attaques par hameçonnage et la génération de logiciels malveillants. Aujourd’hui, nous examinons comment ils utilisent les deepfakes dans leurs attaques. Les deepfakes sont des médias synthétiques qui représentent autre chose que la réalité. C’est dans l’industrie du divertissement que l’on croise le plus souvent ce type de média, mais il est en train de devenir un outil de choix pour la cybercriminalité.

Médias synthétiques et deepfakes

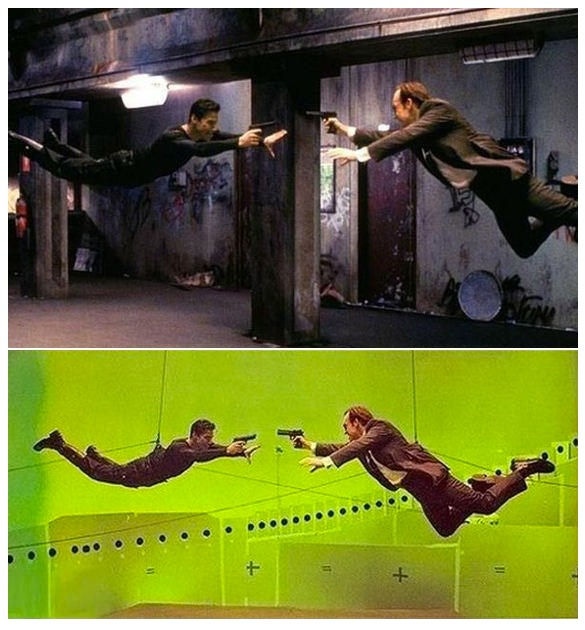

Commençons par clarifier le terme « média synthétique ». Ce terme fait référence à du contenu qui n’est pas tiré de la réalité. Les images, le son, la vidéo, etc. sont synthétisés ou construits par des moyens numériques. L’IA n’est pas nécessaire pour créer des médias synthétiques**. La modélisation 3D, l’imagerie générée par ordinateur (CGI) et d’autres programmes comme Adobe Photoshop peuvent être utilisés pour créer des médias synthétiques sans amélioration de l’IA.

Les médias synthétiques ont de nombreuses utilisations positives en dehors du divertissement. Les étudiants l’utilisent pour apprendre l’anatomie et les ingénieurs pour créer des modèles industriels complexes. Ils sont largement utilisés dans les domaines du marketing, de la publicité, de la formation et du service client. Les médias synthétiques ne constituent pas un risque en soi. Les deepfakes sont un sous-ensemble des médias synthétiques, et c’est là que réside l’essentiel de la menace.

Le terme « deepfake » est la combinaison de « deep learning » et de « fake ». Mais tous les deepfakes ne sont pas dangereux. Certains sont utilisés à des fins ludiques ou commerciales. Les deepfakes ont permis au jeune Luke Skywalker d’apparaître dans The Mandalorian et à Anthony Bourdain de prononcer, à titre posthume, de nouveaux mots dans le film consacré à sa vie. Si le premier deepfake a ravi les fans, le second était troublant et a été largement critiqué. Aucun de ces deepfakes ne présente de risque, mais tous deux montrent le potentiel de cette technologie. Ce qui est effrayant avec les deepfakes, ce n’est pas que Disney puisse recréer un jeune Luke Skywalker, mais qu’un cybercriminel puisse recréer votre patron. Le deepfake trompeur et malveillant constitue la menace, et les attaques utilisant ce type de deepfake sont de plus en plus audacieuses et étendues.

La cybercriminalité et les deepfakes

Des deepfakes malveillants font parfois irruption dans des campagnes électorales, de fausses vidéos de célébrités, les médias et même des procédures judiciaires qui s’appuient sur des preuves vidéo ou audio. Nous allons aborder la cybercriminalité, mais il existe une tonne d’informations sur ces autres sujets.

Le premier incident de deepfake significatif s’est produit en 2017, lorsqu’un utilisateur de Reddit appelé « DeepFakes » a publié des vidéos pour adultes dans lesquelles les visages des acteurs étaient remplacés par ceux de célébrités. Il ne s’agit pas d’une attaque, mais l’incident a marqué les esprits et suscité une indignation et une inquiétude généralisées concernant les violations de la vie privée et la détection des deepfakes. Reddit et d’autres plateformes sociales ont interdit le contenu et banni l’utilisateur et quelques organismes législatifs ont réagi en adoptant des lois interdisant la pornographie deepfake et l’utilisation non autorisée de l’image d’une personne.

Hameçonnage vocal ou vidéo

La plus ancienne attaque par hypertrucage connue a eu lieu en 2019, lorsqu’un acteur malveillant s’est fait passer pour un haut dirigeant et a ordonné à un PDG subalterne de transférer des fonds à un faux fournisseur. Le criminel a utilisé l’hameçonnage vocal, ou vishing, pour manipuler sa victime.

Le PDG de l’entreprise, en entendant le léger accent allemand et la voix familière de son patron, n’aurait rien soupçonné…

Quelques mois plus tard, un autre groupe de cybercriminels a convaincu un employé de banque de transférer 35 millions de dollars sur plusieurs comptes. Les détails suivants sont tirés du document du tribunal (p2) :

… le 15 janvier 2020, le responsable de la succursale de l’entreprise victime a reçu un appel téléphonique prétendant provenir du siège de l’entreprise. Comme l’appelant avait l’air d’être le directeur de l’entreprise, le responsable de la succursale pensait que l’appel était légitime. Le responsable de la succursale a également reçu plusieurs emails qu’il croyait provenir du directeur et qui étaient liés à l’appel téléphonique. L’appelant a indiqué au responsable, par téléphone et par email, que l’entreprise victime était sur le point d’acquérir une autre société et qu’un avocat nommé Martin Zelner (Zelner) avait été autorisé à coordonner les procédures relatives à l’acquisition. Le responsable de la succursale a ensuite reçu plusieurs emails de Zelner concernant l’acquisition, dont une lettre d’autorisation du directeur à Zelner. À la suite de ces communications, quand Zelner a demandé au responsable de la succursale de transférer 35 millions de dollars américains sur plusieurs comptes lors de l’acquisition, le responsable a suivi ses instructions. L’enquête émiratie a révélé que les accusés avaient utilisé la technologie « deep voice » pour simuler la voix du directeur. En janvier 2020, des fonds ont été transférés de l’entreprise victime vers plusieurs comptes bancaires dans d’autres pays dans le cadre d’un système complexe impliquant au moins 17 accusés connus et inconnus.

Cette attaque ne reposait pas entièrement sur le vishing. Il y avait également de faux emails, de fausses personnes (Zelner), de fausses transactions commerciales et plusieurs comptes bien réels créés sous de faux prétextes.

Fausses réunions vidéo

Une autre attaque par deepfake sophistiquée s’est produite en février 2024, lorsque des cybercriminels ont pris pour cible une multinationale basée à Hong Kong :

«… Le collaborateur était devenu méfiant après avoir reçu un message qui provenait prétendument du directeur financier de l’entreprise, basé au Royaume-Uni. Au départ, le collaborateur a pensé qu’il s’agissait d’un email d’hameçonnage, car il était question d’effectuer une transaction secrète.

Cependant, le collaborateur a mis ses soupçons de côté après l’appel vidéo, car d’autres personnes présentes avaient l’air d’être des collègues qu’il reconnaissait…

…Croyant que tous les autres participants à l’appel étaient réels, le collaborateur a accepté de verser un total de 200 millions de dollars de Hong Kong, soit environ 25,6 millions de dollars américains…

Selon la police de Hong Kong, « tous les participants [qu’il avait vus] étaient des imposteurs ».

Il s’agit d’une autre attaque en plusieurs étapes. Les cybercriminels ont fait des recherches sur l’entreprise, étudié des vidéos accessibles au public et utilisé cette reconnaissance pour recréer plusieurs employés lors d’une vidéoconférence. De faux emails et scénarios ont été créés pour permettre le scam et recevoir l’argent.

Il est possible que ces attaques soient bien plus complexes que nous ne le pensons. Les cybercriminels ont peut-être utilisé une menace persistante avancée (APT) pour recueillir des informations sur le réseau, ou il y a peut-être eu une menace interne. Quel que soit le travail de préparation effectué en amont, ils ont pu créer des deepfakes très efficaces.

Extorsion

Les attaques par deepfake ne visent pas simplement à inciter quelqu’un à effectuer une transaction commerciale frauduleuse. Les cybercriminels peuvent créer des scénarios de deepfake qui compromettent les individus et les entreprises. La vidéo d’un PDG parlant ou agissant de manière controversée peut entraîner une baisse du cours des actions, des pertes de ventes et une série de commentaires furieux sur Internet qui ne disparaitront jamais. Des études ont montré que c’est dans les 24 heures qui suivent un incident que se produisent la plupart des dommages à la réputation. Les criminels créent ces deepfakes dommageables, puis tentent d’extorquer de l’argent en échange de la non-diffusion du contenu.

Protégez-vous des attaques par deepfake

Il n’existe pas de moyen unique de vous protéger d’une attaque par deepfake. Comme pour la plupart des cybercrimes, il faut miser sur la formation, la vigilance et plusieurs niveaux de sécurité. Les attaques par deepfake réussies, comme celles mentionnées ci-dessus, ont nécessité une série d’événements, notamment une reconnaissance et de multiples types d’attaques par e-mail. De telles attaques peuvent être évitées très tôt grâce à une plateforme complète de cybersécurité et à une formation continue de sensibilisation à la sécurité. Vous pouvez également revoir les paramètres de confidentialité des comptes de réseaux sociaux et limiter les types d’informations publiées par l’entreprise.

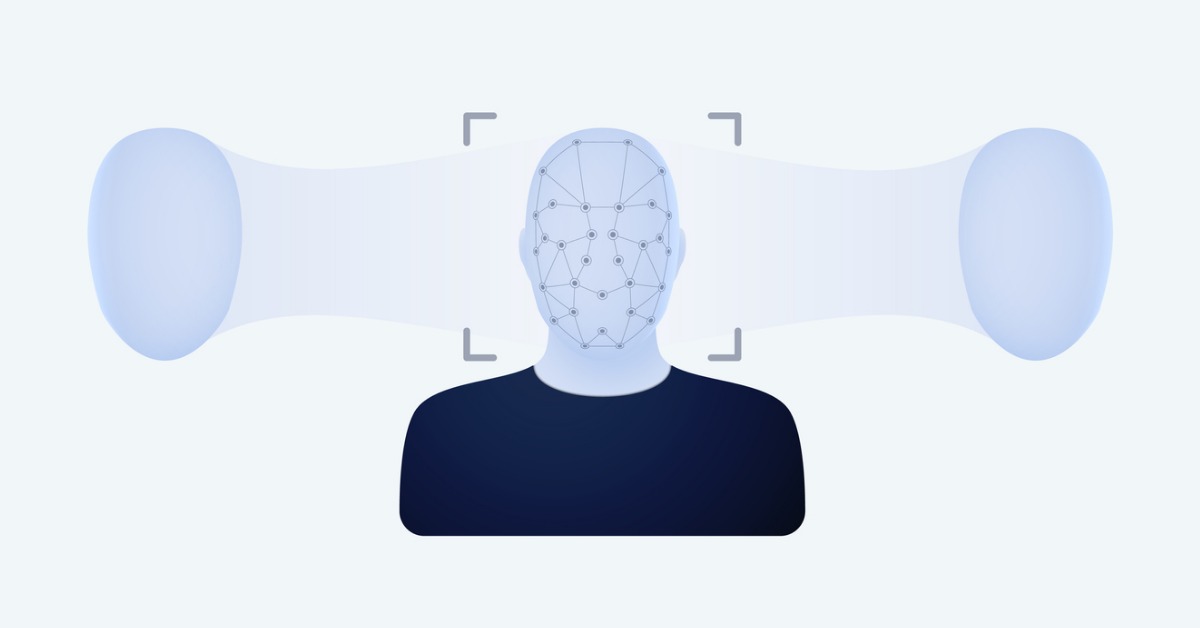

Si les deepfakes ne cessent de s’améliorer, ils sont rarement parfaits. Soyez attentif aux mouvements étranges des yeux ou du visage, ainsi qu’aux ombres et à l’éclairage incohérents en arrière-plan. Vérifiez l’authenticité de toute communication inhabituelle. La philosophie Zero Trust est une défense solide contre les deepfakes. Ne jamais faire confiance, toujours vérifier. Partez du principe que l’environnement est hostile et scrutez les moindres détails.

Saviez-vous que...

Selon un rapport récent de Barracuda et du Ponemon Institute, 50 % des professionnels de l’informatique s’attendent à une augmentation du nombre d’attaques en raison de l’utilisation de l’IA. Découvrez tous les détails à ce sujet et bien plus encore dans notre nouvel e-book, Sécuriser demain : Guide du RSSI sur le rôle de l’IA dans la cybersécurité. Cette nouvelle publication traite des menaces contre la sécurité. Elle présente les vulnérabilités que les pirates informatiques exploitent avec l’aide de l’IA pour intensifier leurs attaques et mieux les réussir. Demandez dès maintenant votre exemplaire gratuit de cet e-book et découvrez les menaces, les données, les analyses et les solutions les plus récentes.

**Pour des lectures intéressantes sur les images d’IA et les graphismes générés par ordinateur, consultez ce fil de discussion Quora.

Rapport 2025 sur les ransomwares

Principales conclusions concernant l’expérience et l’impact des ransomwares sur les organisations du monde entier

S’abonner au blog de Barracuda.

Inscrivez-vous pour recevoir des informations sur les menaces, des commentaires sur le secteur et bien plus encore.

Sécurité des vulnérabilités gérée : correction plus rapide, risques réduits, conformité simplifiée

Découvrez à quel point il peut être facile de trouver les vulnérabilités que les cybercriminels cherchent à exploiter